A Unified Approach to Interpreting Model Predictions

Requests for name changes in the electronic proceedings will be accepted with no questions asked. However name changes may cause bibliographic tracking issues. Authors are asked to consider this carefully and discuss it with their co-authors prior to reque

papers.nips.cc

0. Abstrct

- Additive feature attribution methods에서 게임이론을 기반으로 하는 Shap Value가 유일한 해임을 밝힘.

- 또한 Shap Value가 여러 모델의 해석에 사용될 수 있으며, 기존 설명 방법들을 통합할 수 있는 등 매우 훌륭한 방법임을 증명

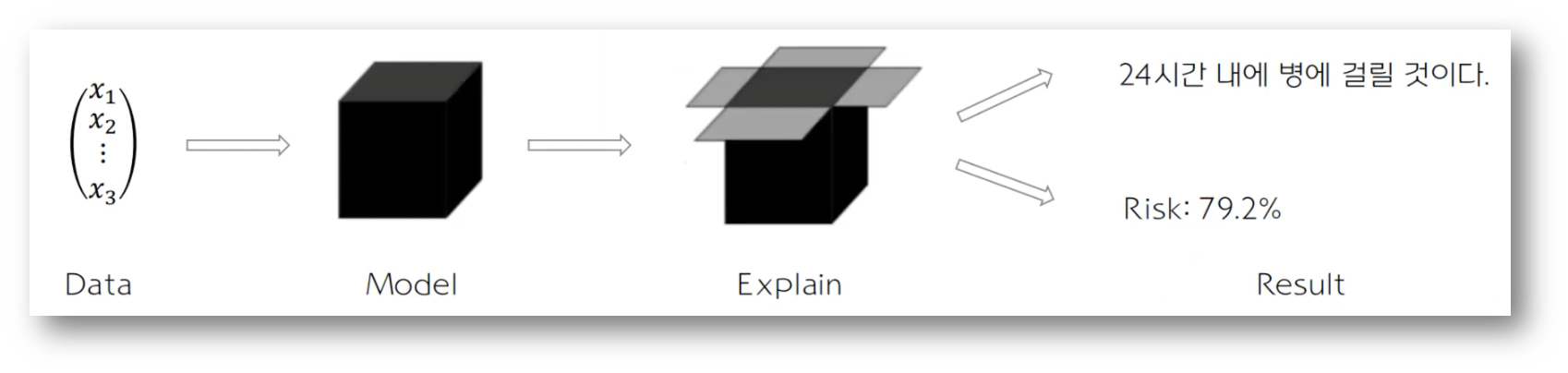

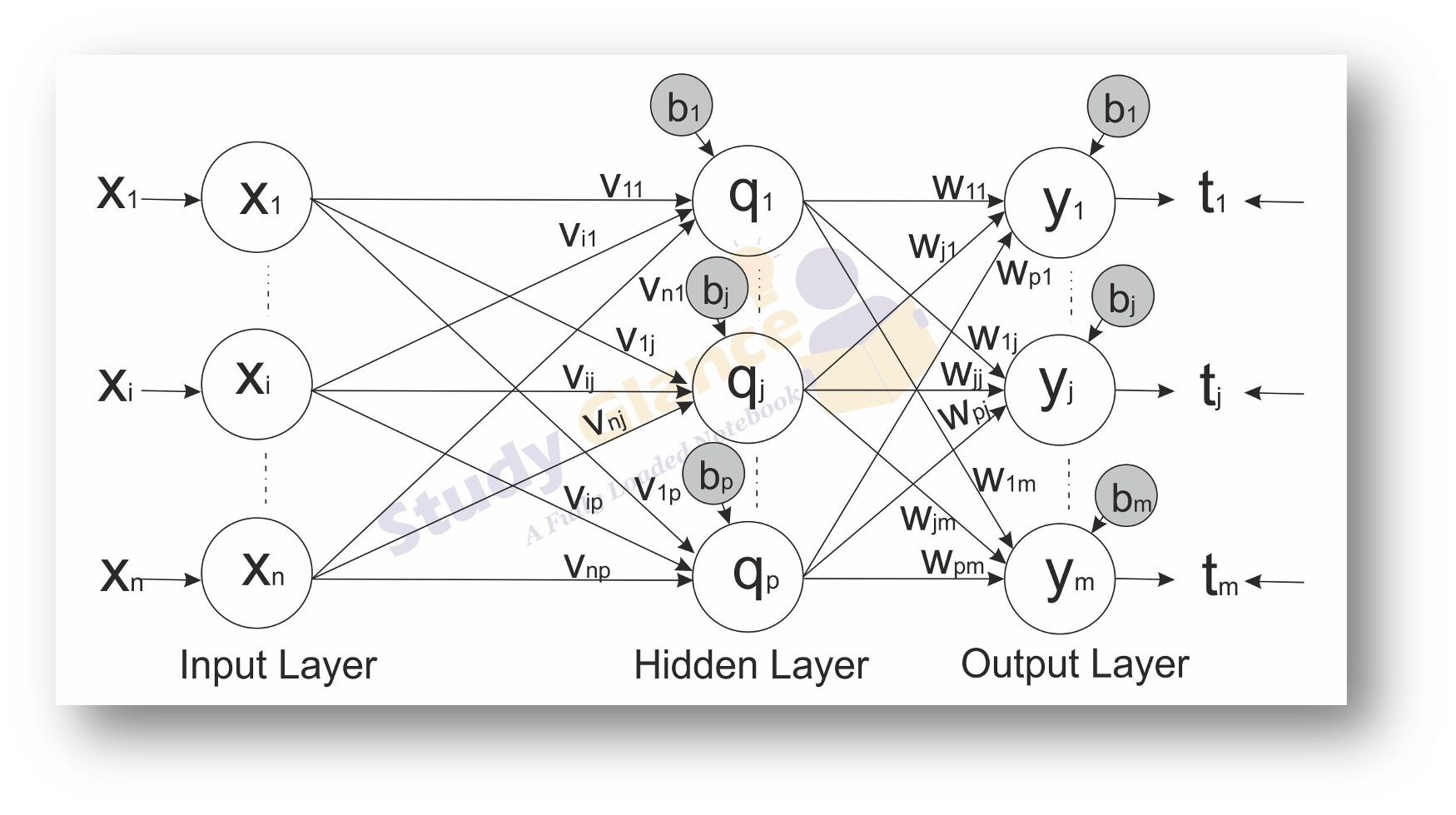

Black-Box Model과 XAI(설명가능한 AI)

- Black-Box: 모델에 input이 들어와 prediction을 수행했을때, 왜 그런 prediction을 도출했는지 알 수 없음

- ML의 Black-Box와 같은 특징은 모델 신뢰를 떨어뜨리고 도입을 어렵게 하는 주요 원인

- 이러한 문제를 해결하려는 연구 분야가 설명가능한 AI (XAI)

- LIME, Feature Importance, PDP plot, Shap Value

2. Background

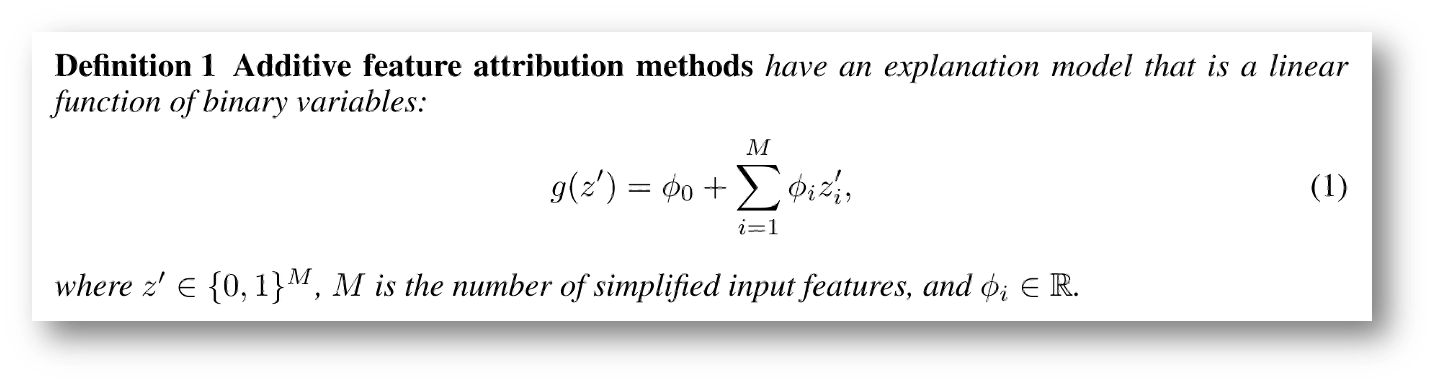

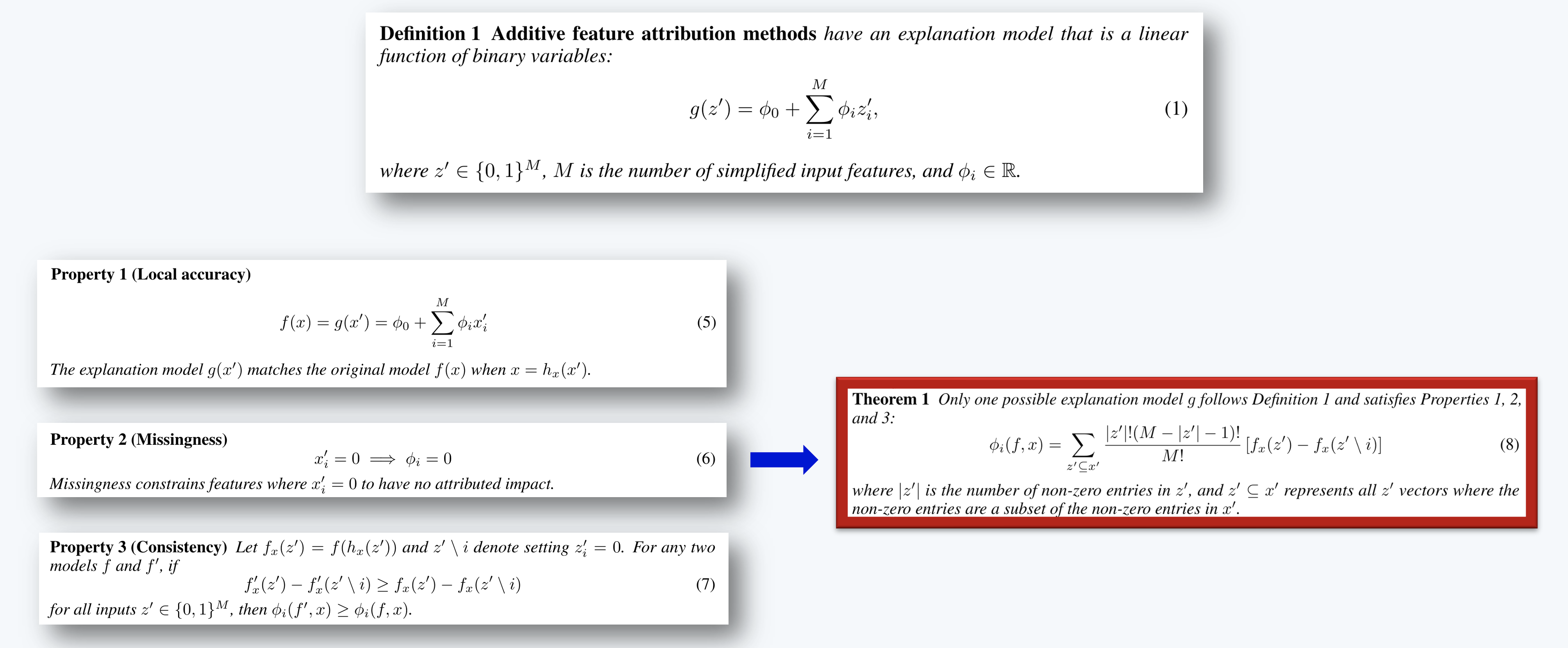

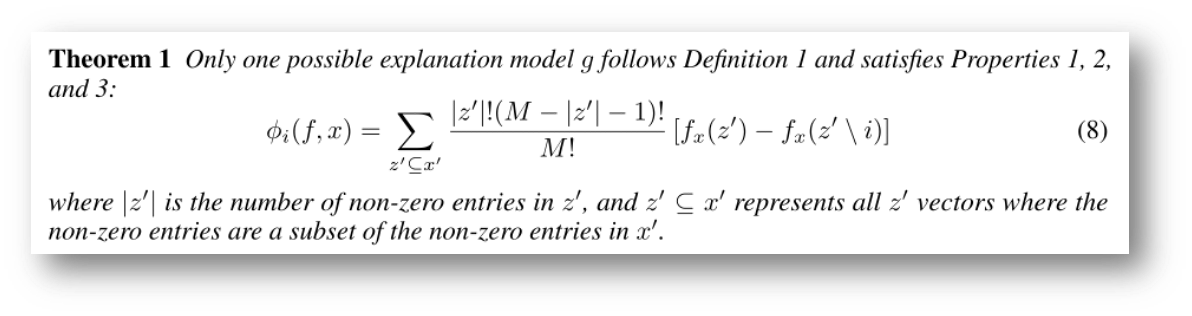

(1) Addictive feature attribution methods

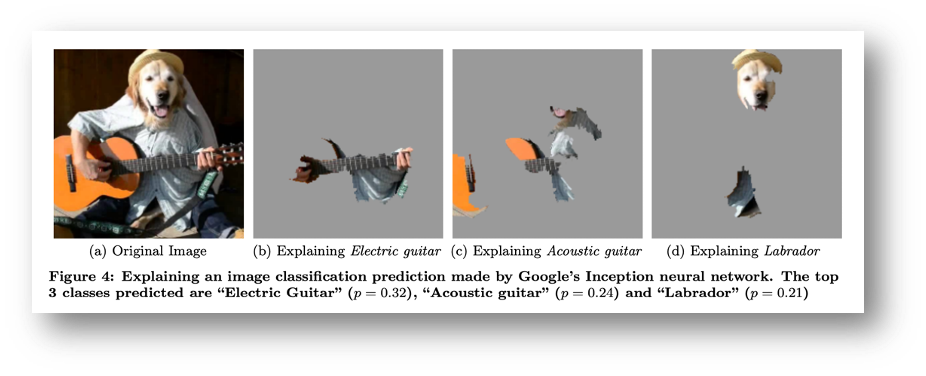

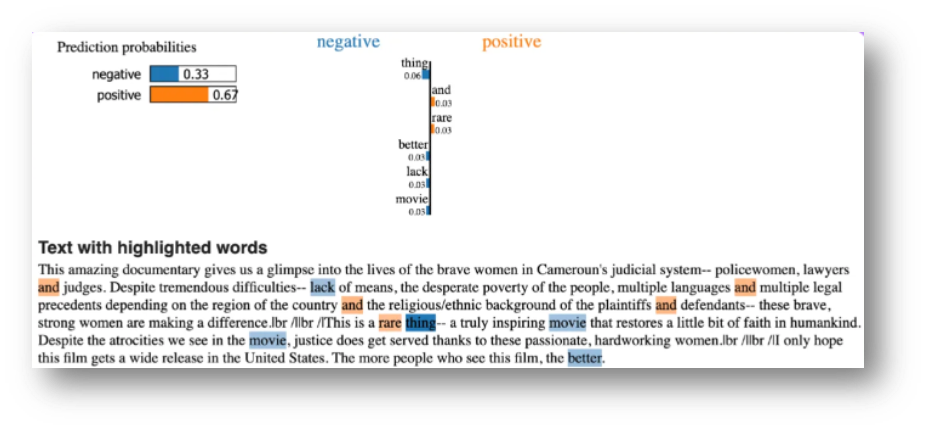

(2) LIME (Local Interpretable Model-agnostic Explanations)

(3) DeepLIFT

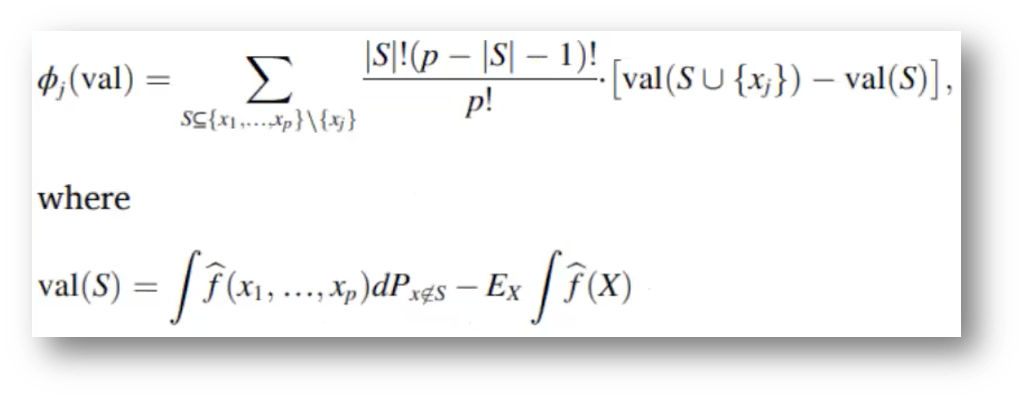

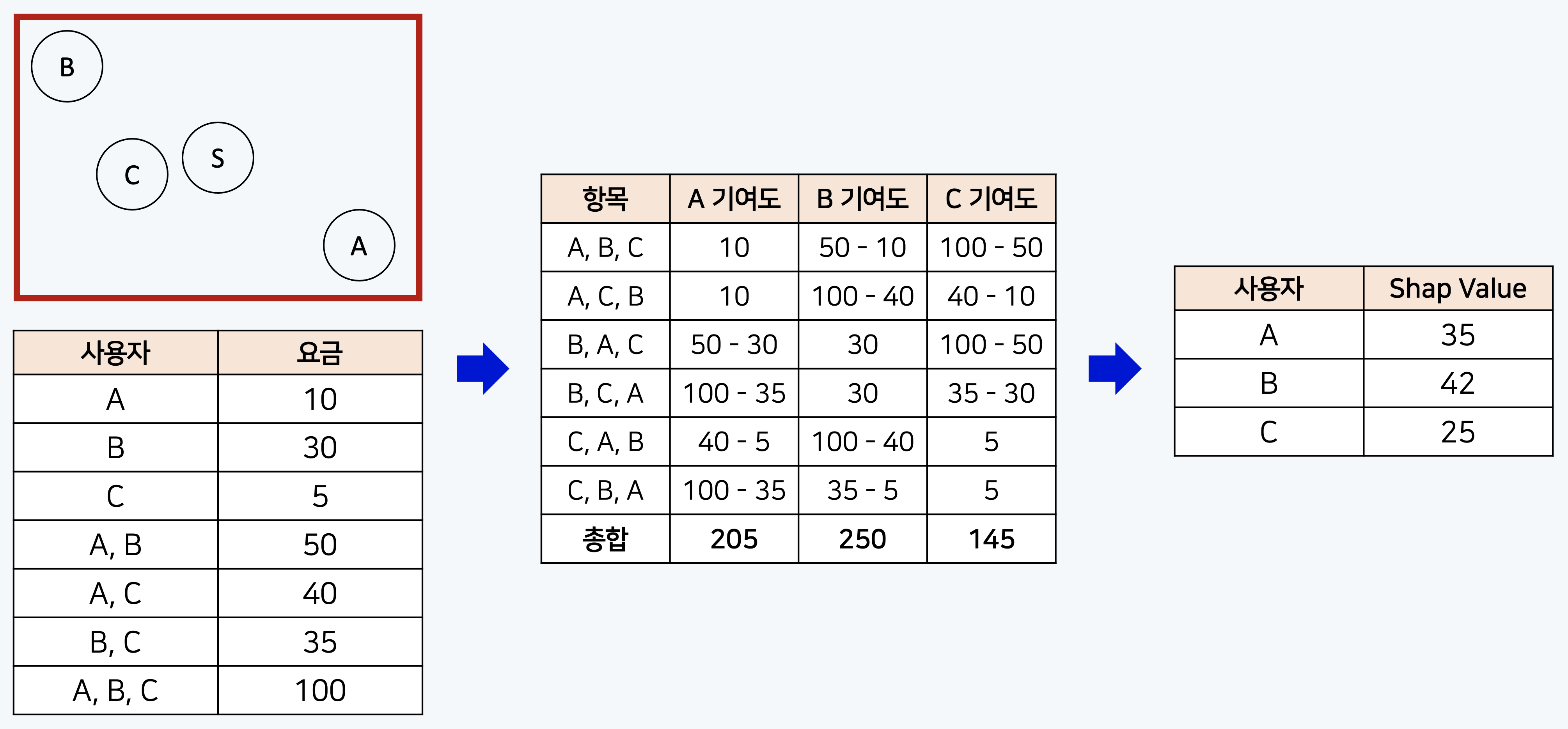

3. Shap Value

(1) Shap Value

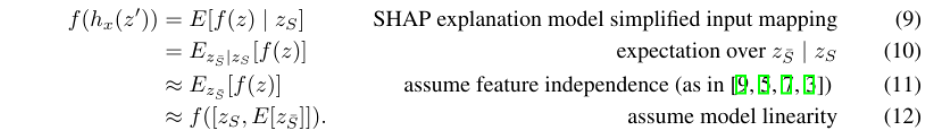

(2) Kernel SHAP

(3) 기타 SHAP

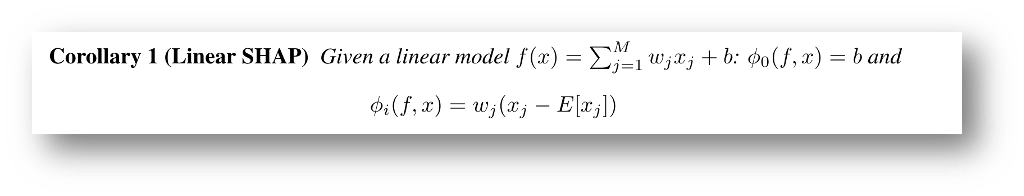

- Linear SHAP

- Low-Order SHAP

- Max SHAP

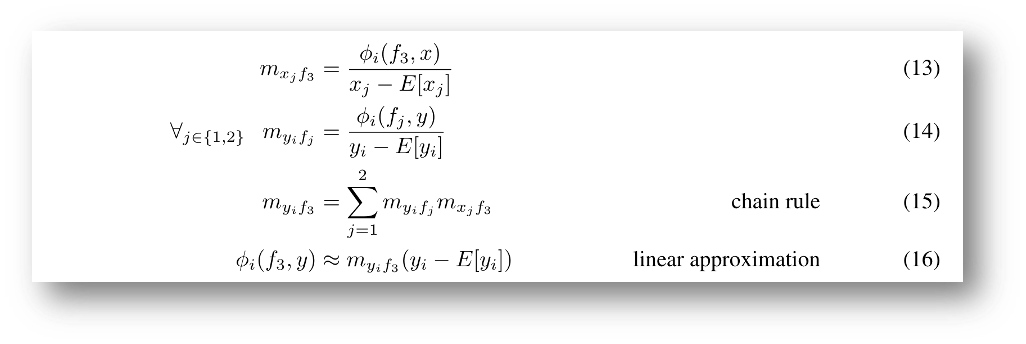

- Deep SHAP (DeepLIFT + Shapley values)

4. XAI - SHAP

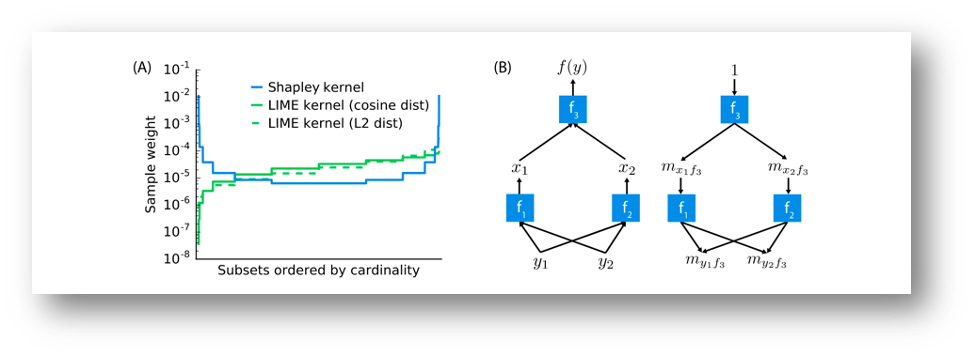

(A) Shapley kernel weight는 symmetric(대칭) ➞ LIME에 비해 매우 안정적

(B) 심층신경망과 같은 합성곱 모델은 간단한 구성요소로 이루어져, 구성요소의 shapley 값에 대한 분석이 주어지면 전체 모델에 대한 근사치를 DeepLIFT의 역전파와 같은 방식을 사용하여 만들 수 있음

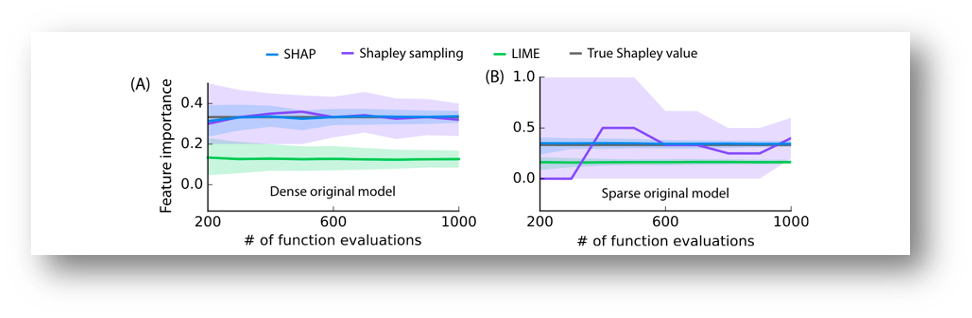

원래 모델 함수의 평가 횟수가 증가함에 따라 두 모델에서 하나의 특징에 대한 특징 중요도 추정치가 표시

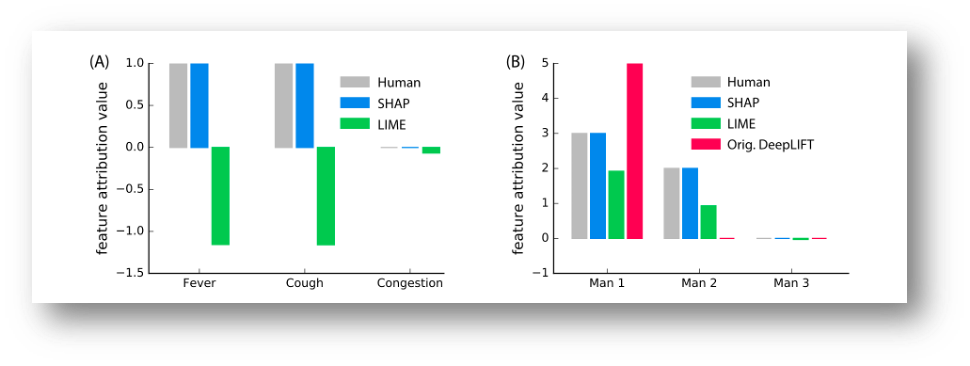

(A) 단일 입력에 대해 10개의 입력 특징을 모두 사용하는 의사 결정 트리 모델을 설명

(B) 100개의 입력 특징 중 3개만 사용하는 의사 결정 트리가 단일 입력에 대해 설명

MNIST 숫자 데이터 세트에 대해 훈련된 컨볼루션 네트워크의 출력 설명했다. Original DeepLIFT에는 명시적인 Shapley 근사치가 없는 반면, New DeepLIFT는 Shapley Value를 더 잘 근사화하려고 노력했다.

(A) 빨간색 영역은 해당 클래스의 확률을 높이고, 파란색 영역은 확률을 낮춘다. 마스킹은 픽셀을 제거하여 8에서 3으로 이동한다.

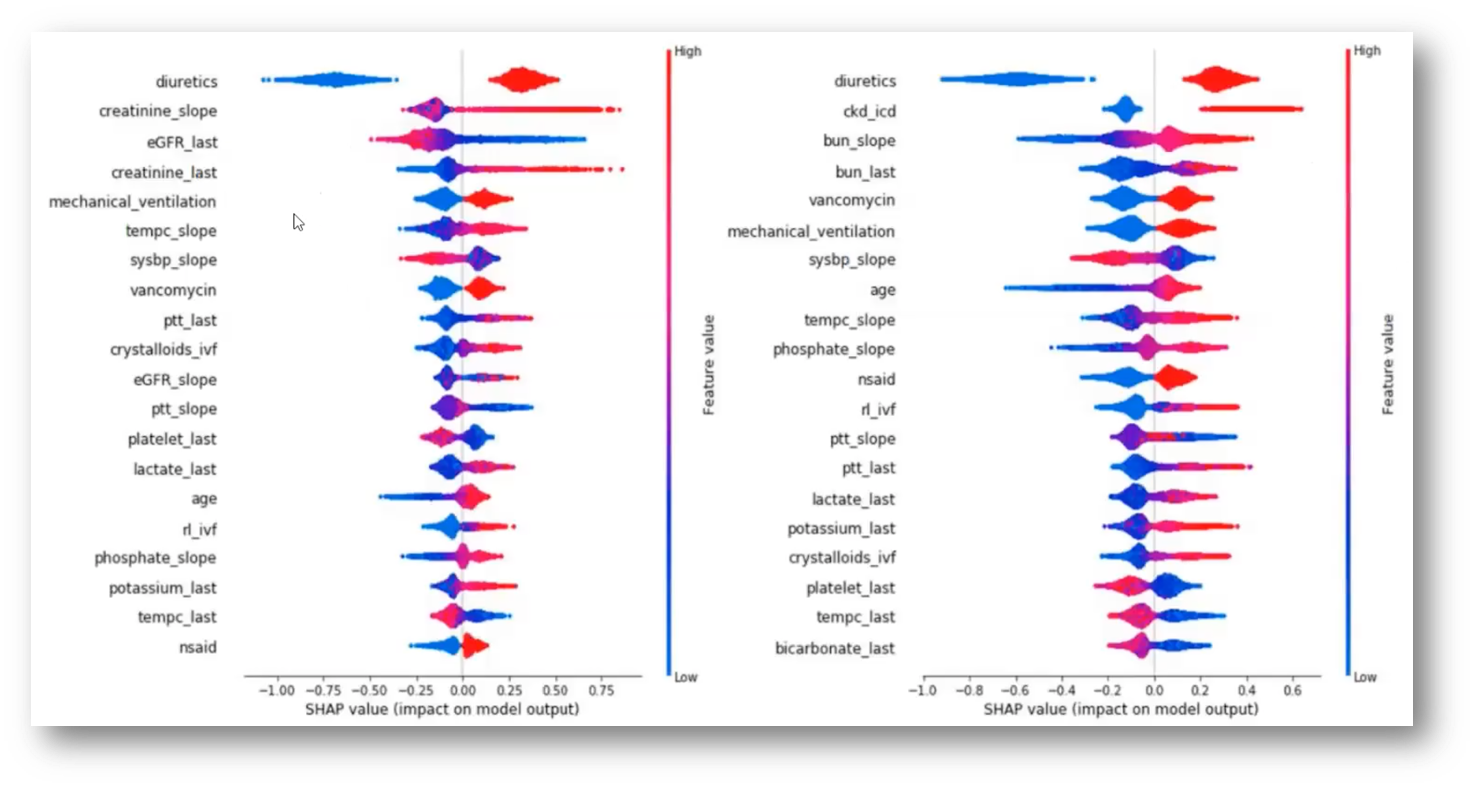

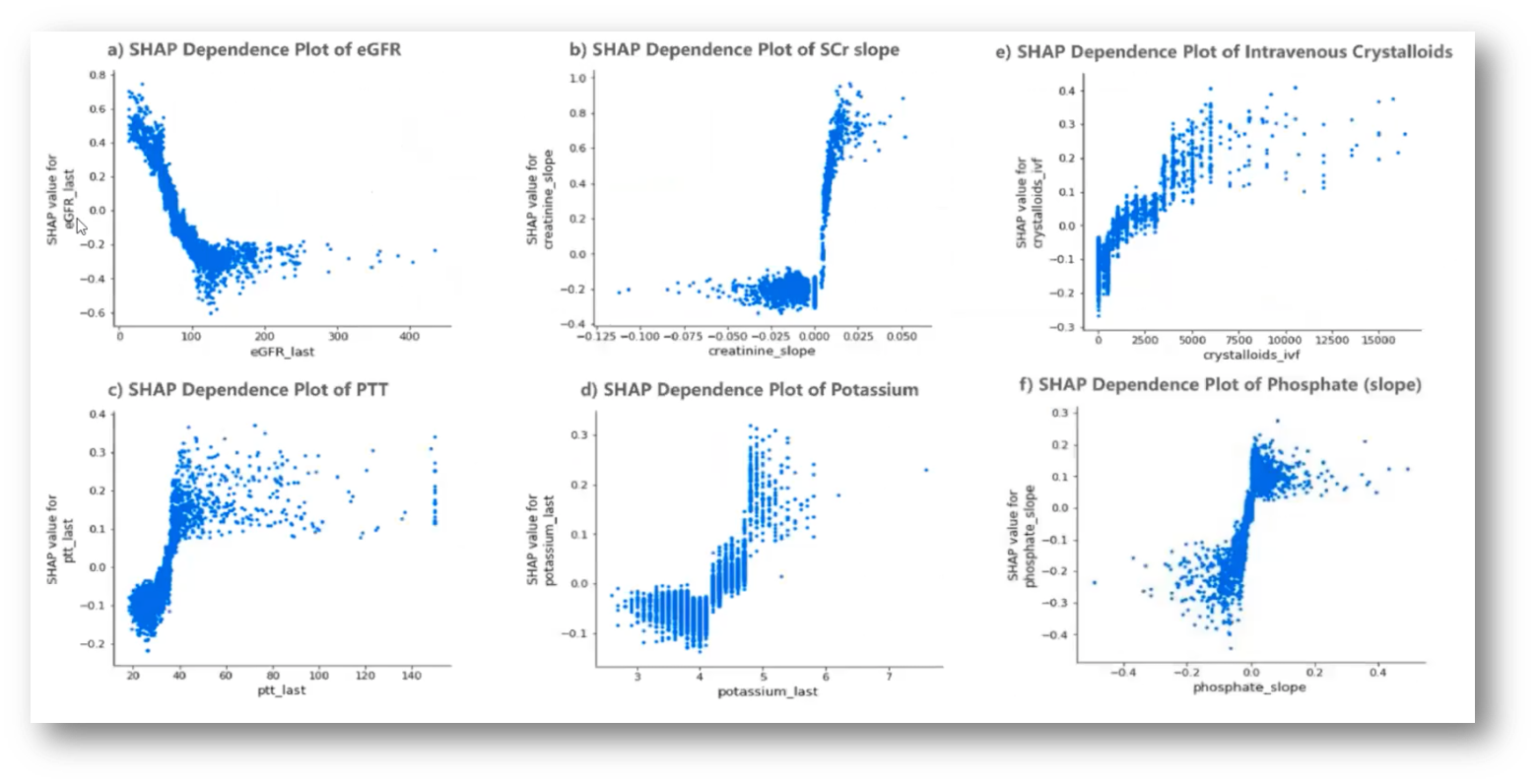

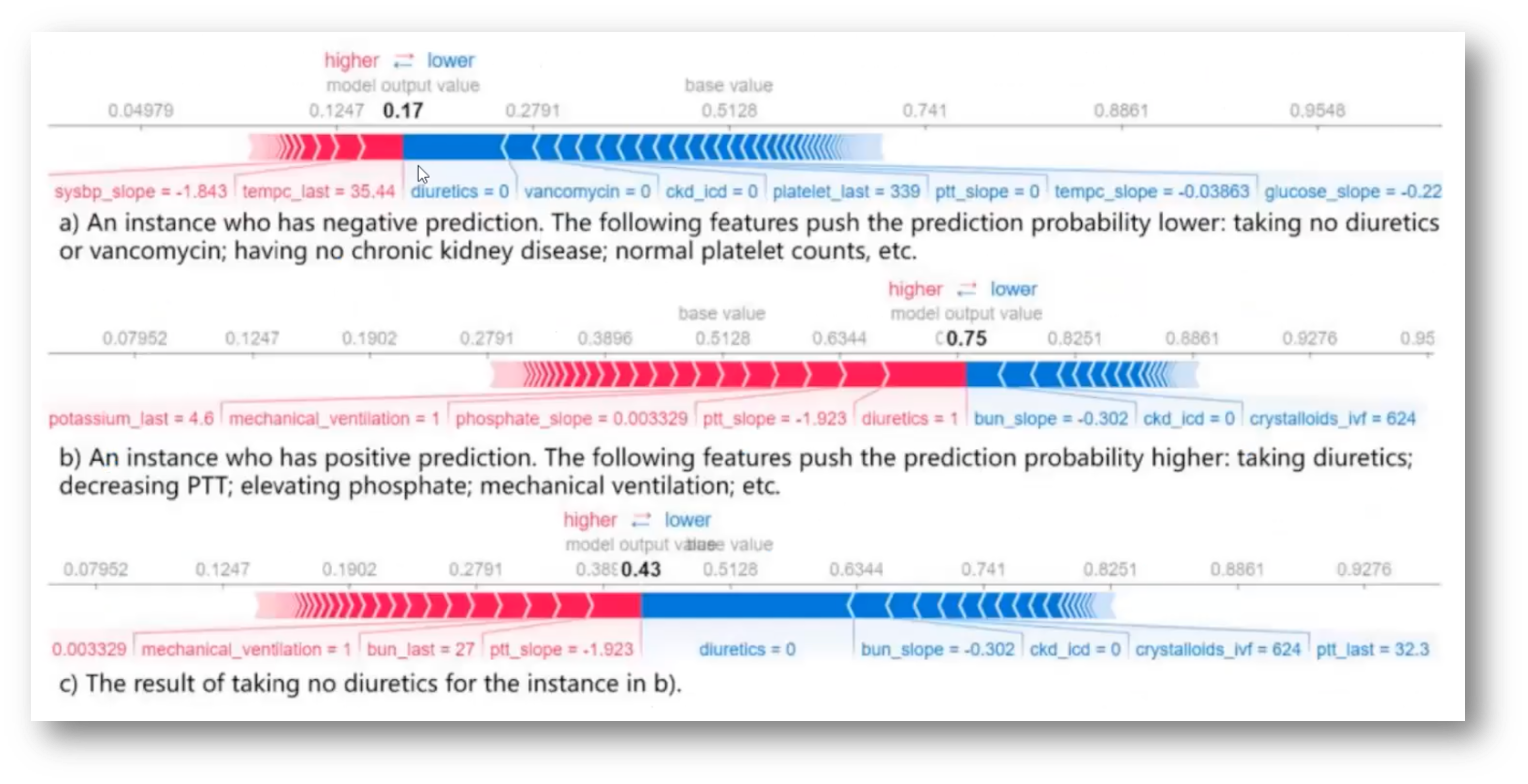

5. Interpretation

(1) Global Interpretation

(2) Local Interpretation

'CV' 카테고리의 다른 글

| VoxelMorph: A Learning Framework for Deformable Medical Image Registration (2) | 2024.11.07 |

|---|---|

| (DeepSORT) SIMPLE ONLINE AND REALTIME TRACKING WITH A DEEP ASSOCIATION METRIC (1) | 2024.05.07 |

| ResNet (0) | 2024.04.22 |

| GoogLeNet (0) | 2024.04.22 |

| VGG (0) | 2024.04.22 |