1. 서포트 벡터 머신 (SVM)

선형 SVM vs 비선형 SVM

- 선형 SVM : 하드 마진(Hard Margin) SVM, 소프트 마진(Soft Margin) SVM

- 비선형 SVM : 커널(Kernel) SVM

2. 비선형 SVM

(1) 비선형 SVM

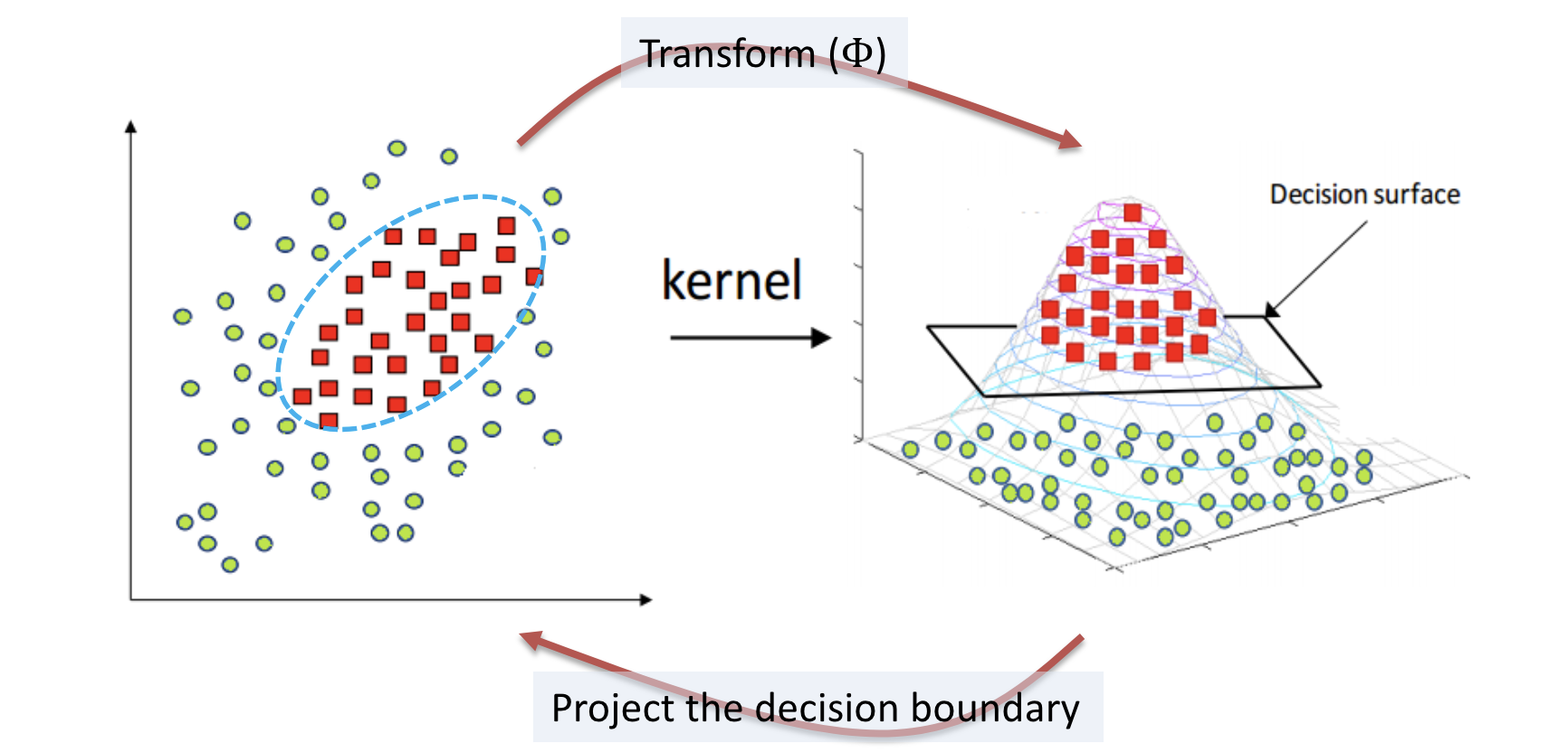

- 데이터를 선형으로 분류하기 위해 차원을 높이는 방법을 사용

- Feature Map($\Phi$)을 통해 차원을 높임, $X$ 대신에 $ \Phi(X)$ 사용

- 커널: Feature Ma의 내적

(2) 비선형 SVM의 해법

- SVM 모델을 original space가 아닌 feature space에서 학습

- Original Space에서 nonlinear decision boundary → Feature space에서 linear decision boundary

- 고차원 feature space에서는 분류가 더 쉬울 수 있음을 증명함

- 고차원 feature space를 효율적으로 계산할 수 있는 방법이 있음

(3) 비선형 SVM의 목적함수

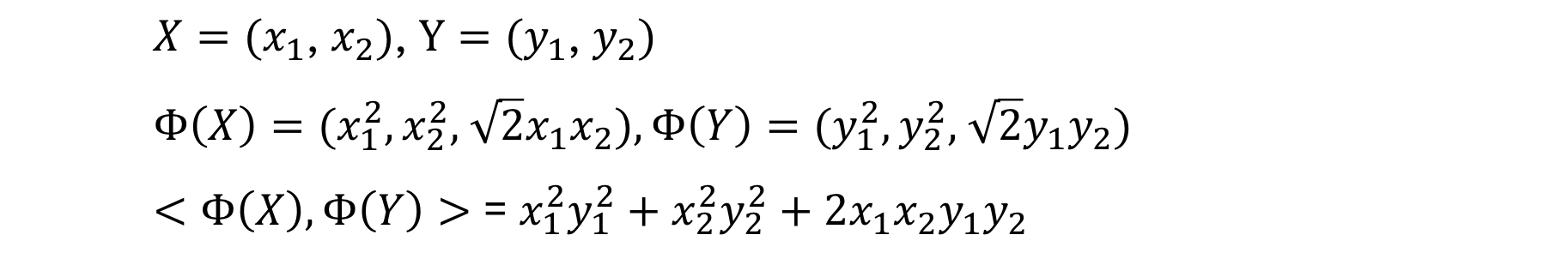

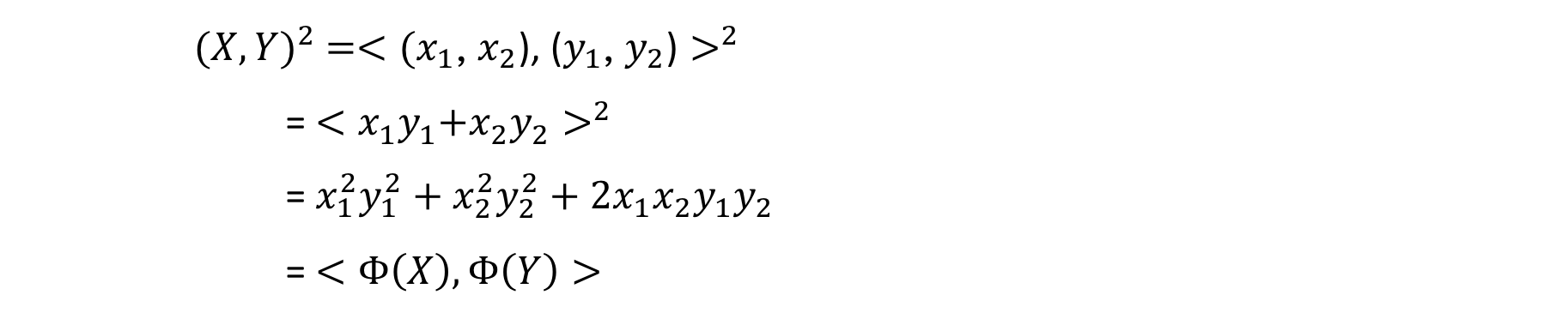

(4) Kernel Mapping

커널 사용을 통해 명시적으로 $\Phi(X)$, $\Phi(Y)$를 각각 계산하지 않고, 암묵적으로 $<\Phi(X), \Phi(Y)>$를 바로 계산하여 연산 효율을 높일 수 있음

$(X,Y)^2=<(x_1,x_2),(y_1,y_2)>^2=K(X,Y)$ → Kernel Function

(5) Kernel Function의 예

(6) 비선형 SVM의 커널 성정법

SVM Kernel을 결정하는 것은 어려운 문제

- 정해진 기준이 없으므로, 실험적으로 결정

사용하는 kernel에 따라 feature space의 특징이 달라지기 때문에 데이터의 특성에 맞는 kernel을 결정하는 것은 중요함

- 일반적으로 RBF Kernel, Sigmoid Kernel, Low Degree Polynomial Kernel (4차 미만) 등이 주로 사용됨

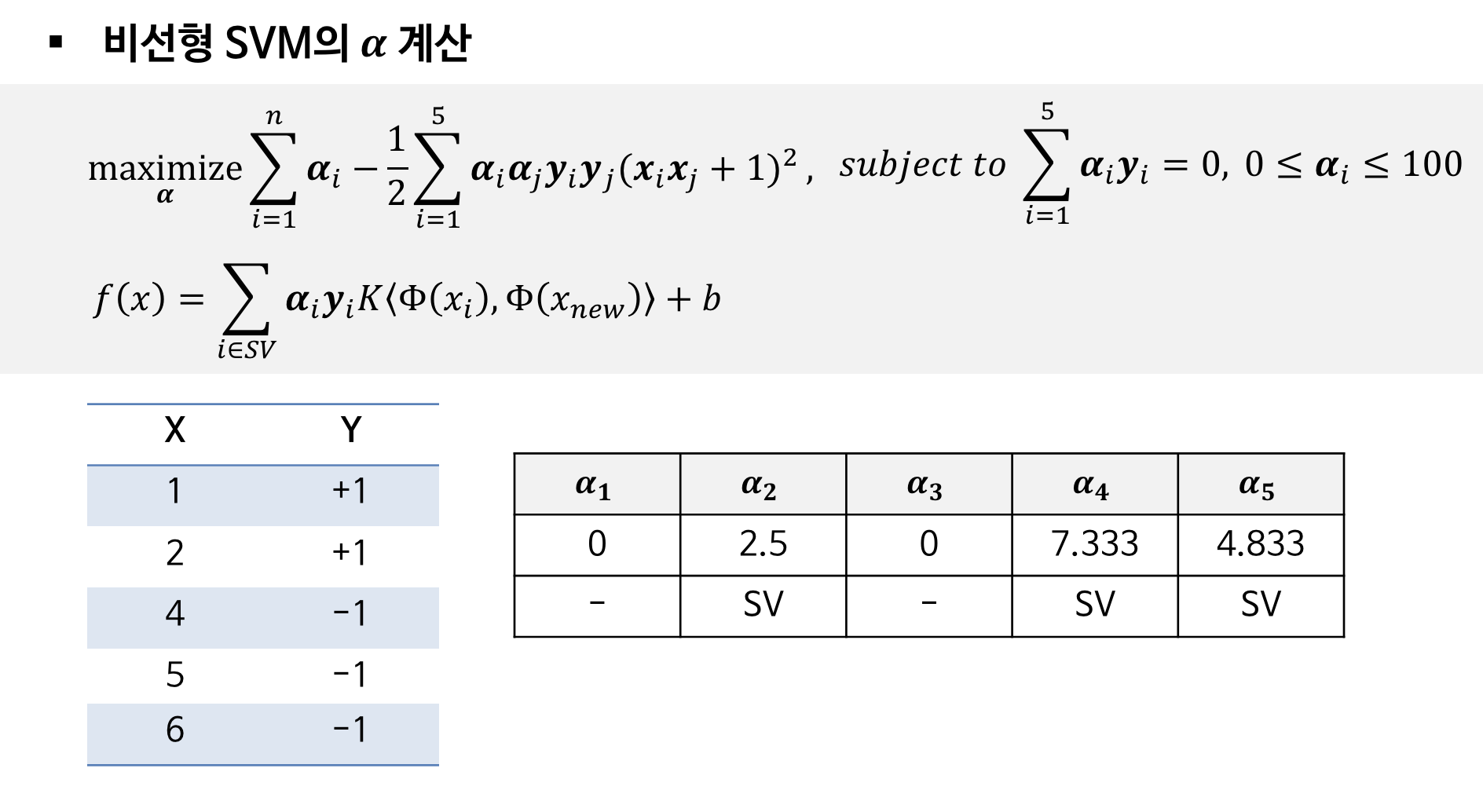

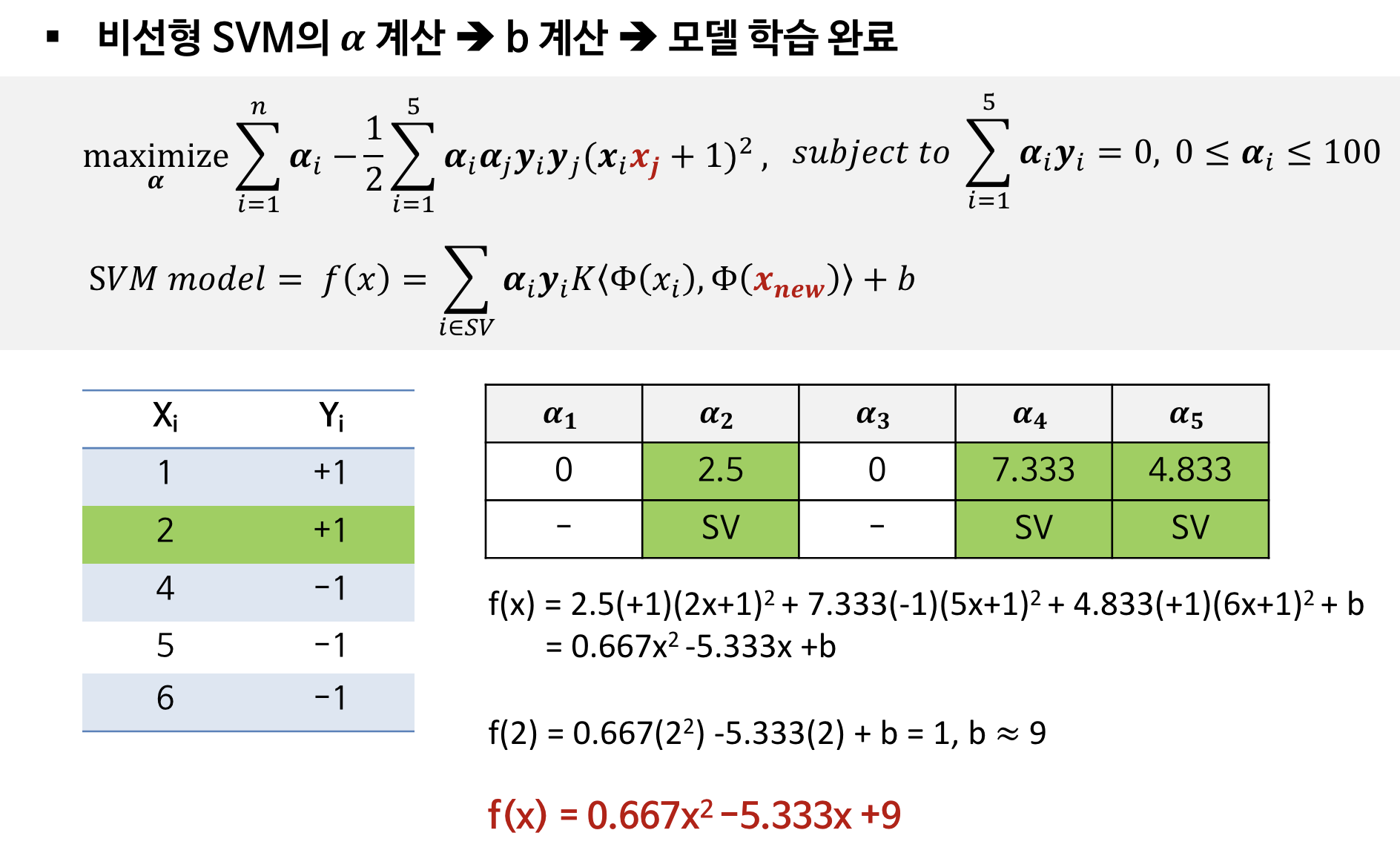

3. 비선형 SVM의 예

'Computer Science > Machine Learning' 카테고리의 다른 글

| 앙상블(Ensemble) (1) (2) | 2024.06.09 |

|---|---|

| SVM 다계층 분류 (4) (0) | 2024.06.09 |

| Linear SVM : Soft Margin SVM (2) (0) | 2024.06.09 |

| Linear SVM : Hard Margin SVM (1) (1) | 2024.06.09 |

| 의사결정나무(Decision Tree) (3) (1) | 2024.06.09 |